衆議院議員選挙は2月8日投開票です。テレビ朝日では選挙期間中、SNSのうち、X・YouTube・TikTokの分析調査を実施します。SNS分析を監修する立命館大学産業社会学部・谷原つかさ准教授の寄稿を紹介します。

SNSの解像度を上げるには

2024年の衆院選や、2025年の参院選において、SNSは選挙戦の重要な要素としての地位を確立しました。今回の衆院選でも、特に若年層や無党派層にとっては、政治情報を得る重要なメディアとして機能すると思われます。

筆者はこれまで、SNSと選挙に関する報道に協力をさせていただきました。メディアから必ずと言ってよいほど最後に質問されたのは、「SNSと向き合う際に注意すべきこと」でした。

最新の動向を踏まえると、この質問に一言で答えるのはやや困難です。そこで本稿では、SNSの「解像度」をグッと上げ、それを正しく理解したうえで向き合う姿勢を、読者の皆様が自ら考えられるようになることを目指したいと思います。

SNSと一口に言っても中身はさまざまです。日本における政治コミュニケーションの文脈では、少なくとも、YouTube、X、TikTokという三つのプラットフォームが主なものですが、それぞれ仕様が微妙に異なります。順番に見ていきましょう。

YouTubeが掲げる「四つのR」

YouTubeは2019年に、「The Four Rs of Responsibility」という方針を示しています。

四つのRとは、以下のことです。

Remove―ポリシー違反動画(ポルノ、暴力など)は削除

Raise―伝統的な報道機関などの動画はプッシュする

Reward―信頼できるクリエーターには報酬の機会を与える

Reduce―ポリシー違反すれすれの動画(例えば有害な陰謀論や誤情報など)は露出を減らす

【出典1】

[YouTube Official Blog]

The Four Rs of Responsibility

Part 1: Removing harmful content

Part 2: Raising authoritative content and reducing borderline content and harmful misinformation

これらが本当であれば、YouTubeはかなり抑制的な運用を行っていることになります。実際はどうなのでしょうか。YouTubeのアルゴリズムを検証する科学的研究が英語圏では報告されていますので、それらを参照しましょう。

アルゴリズムに従う方が穏健な傾向

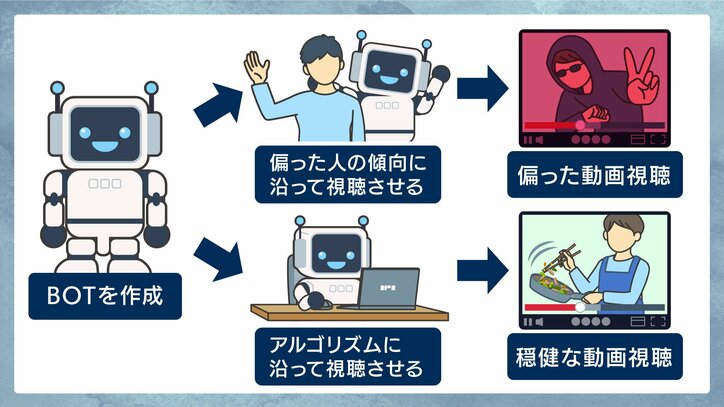

2024年に発表された論文では 、米国のオンライン調査モニター(調査協力者)に登録している人々からYouTube視聴履歴を取得し、それを学習させたGoogleアカウントのボット(振る舞いが自動化されたアカウント)を作成しました。

このボットを二つのグループに分け、一方のボットには、引き続き調査協力者の傾向に従ってYouTubeを視聴させました。もう一方のボットには、「サイドバー(画面横の関連コンテンツ表示)最上位を必ずクリック」「サイドバー上位30本から無作為」「ホーム上位15本から無作為」という、いわばYouTubeのアルゴリズムに盲目的に従う形で、YouTubeを視聴させました。

その結果、アルゴリズムに盲目的に従ったボットは比較的、党派的なユーザー履歴に基づいて視聴したボットよりも、穏健な動画を視聴する傾向にありました。

【出典2】

[Proceedings of the National Academy of Sciences]Causally estimating the effect of YouTube’s recommender system using counterfactual bots

視聴動画の偏りは、個人の心がけで防げる

また、2023年に発表された別の研究では、米国の調査協力者のYouTube視聴履歴を詳細に観察しています。

結果を見ると、過激な動画視聴の50%前後がそのチャンネルの登録者によるものでした。また、「同タイプのチャンネルを一つでも登録したユーザー」による視聴を合わせると、85%前後まで増加しました。さらに、過激な動画視聴時間の80%は、0.6%前後の人々が占有していました。

レコメンド(推奨機能)に関しては、一般的なレコメンドで過激な動画が推奨されることはまれですが、既に過激な動画を視聴しているユーザーには、同類の動画が50%ほど推奨されました。

以上から示唆されるのは、YouTubeは過激な動画視聴に関しては比較的、抑制的な運用を試みている一方で、個人の選択とアルゴリズムが合わさると、フィルターバブル(同じような動画が推薦されること)による偏りの強化が起こるということです。

逆に言えば、個人の心がけ次第で、これは防ぐことができるはずです。たとえば、いくつかおすすめ動画が提示されたら、あえて普段あまり見ないテイストの動画を見てみると世界が広がるかもしれません。

【出典3】

[Science Advances]

Subscriptions and external links help drive resentful users to alternative and extremist YouTube channels

「一部の意見だけど影響力は強い」

もう一つ、気をつけねばならないのはYouTubeのコメント欄です。

英語圏の政治系YouTubeのコメント欄を研究した論文によると 、2%の投稿者が全体の50%のコメントを投稿していました。

【出典4】

[Journal of Quantitative Description: Digital Media]

Pressing Play on Politics: Quantitative Description of YouTube

一方でコメント欄のコメントは、動画への評価や、後続のコメントに影響を与えることも科学的に明らかにされています 。

つまりコメントは「一部の意見だけれども影響力は強い」ということのようです。

動画を見る際はついついコメントをすぐに見に行ってしまいますが、あえて見ずに一度自分だけで動画について考えてみることもよいかもしれません。

【出典5】

[Human Communication Research]

Sharing the Fun? How Social Information Affects Viewers’ Video Enjoyment and Video Evaluations

[Scientific Reports]

The impact of toxic trolling comments on anti-vaccine YouTube videos

Xの“フィルターバブル”は限定的?

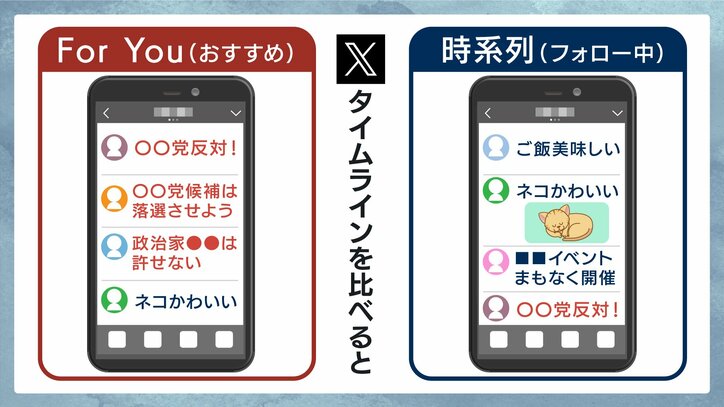

実はXでは、フィルターバブルに対して抑制的な運用が行われています。X社は公式に「For You(おすすめ)のタイムラインは、平均して50%がフォロー中のアカウントによる投稿、50%がフォロー外のアカウントによる投稿で構成される」と説明しています。

【出典6】

[X Engineering]

Twitter’s Recommendation Algorithm

ただし科学研究においては、確かにフォロー外が50%程度ではあるけれど、推薦されるのは一部の人気ポストで、それも右派に偏るバイアスがあったと、南カリフォルニア大学の研究者らによって2025年に報告されています。

【出典7】

[Proceedings of the 2025 ACM Conference on Fairness, Accountability, and Transparency]

Auditing Political Exposure Bias: Algorithmic Amplification on Twitter/X During the 2024 U.S. Presidential Election

他方、安全性に関しては懐疑的な報告もあります。

イーロン・マスク氏による買収後にヘイト的な投稿が増加、ヘイト的な投稿へのエンゲージメント(ユーザーの反応)も増加したことを示す研究が、カリフォルニア大学の研究者らによって2025年に発表されています。

【出典8】

[PLOS ONE]

X under Musk’s leadership: Substantial hate and no reduction in inauthentic activity

また、For Youのタイムライン(表示される投稿の一覧)は、時系列のタイムライン(フォロー中の投稿一覧)と比べて、党派性が強いポストが多いと報告されています。同時に、自分とは違う政治的立場の人たちに対して否定したり攻撃したりする投稿が多いことも報告されています。

【出典9】

[Knight First Amendment Institute at Columbia University]

Engagement, User Satisfaction, and the Amplification of Divisive Content on Social Media

「あなたの好みに最適化」TikTokの特性

TikTokは、YouTubeやXと比べてアルゴリズムの詳細を抽象的にしか開示していないので謎が多いですが、その設計思想は読み取ることができます。簡単に言えば「あなたの好みに最適化」ということです。

【出典10】

[TikTok Newsroom]

How TikTok recommends videos #ForYou

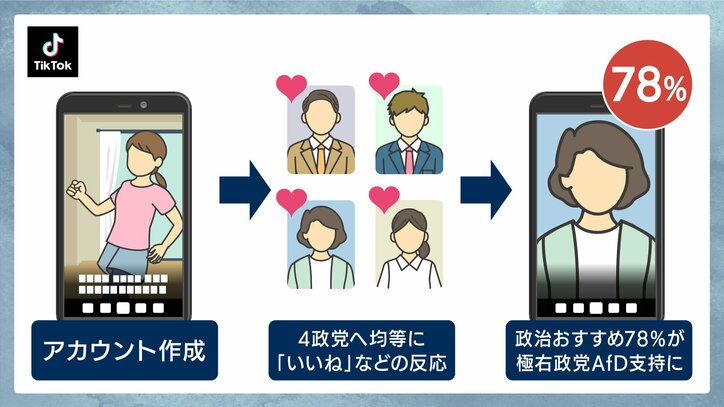

ある国際NGOは次のような検証を行いました 。ドイツのベルリンで、「中立的ではあるが政治関心があるアカウント」を作成。4大政党(CDU、SPD、AfD、緑の党)及びその党首をフォロー、それぞれ均等に「Like」(日本版では「いいね」)などの反応を行い、偏りが生じないように運用した状態を15分続けると、おすすめ動画の表示がどうなるかを観察しました。

結果は、TikTokで推薦された政治コンテンツのうち、78%が極右政党であるAfDへの支持的なコンテンツでした。

これに関して、このNGOがTikTokに質問を投げかけましたが、TikTokは「特定政党を優遇してはいない」と反論しました。

おそらく、そもそも拡散力の高いコンテンツがおすすめされるので、党派性はなくとも、高い拡散力を有するAfD的なコンテンツがおすすめされやすかったのではないかと考えられます。

【出典11】

[Global Witness]

X and TikTok algorithms push pro-AfD content to non-partisan German users: New analysis

ただし公式の説明によると、確かに「バズった動画」も推薦される可能性が高いですが、それ以上に「あなたの好み」が優先されるようです(TikTokでは、あまり再生されていない動画でも、あなたの好みに合えばおすすめに上がることがありますよね)。

おすすめ動画の多様性についての記述もあり、同一のクリエーターや同一の音源の連続表示を避けているそうですが、YouTubeやXと比較して、「あなたの好みに最適化」という仕様は、比較的強いフィルターバブルを生み出すでしょう。

ここまで見てきたように、SNSと一口に言っても、プラットフォームごとに特性があります。それぞれクセがありますが、最後に何を信じ、何を保留するかを決めるのは私たち自身です。仕組みを理解することは、判断の主導権を取り戻すことでもあります。

この記事の画像一覧