さまざまな企業が独自の生成AIを開発し、個人や企業での活用が進んでいる昨今。そんな中、AIに対する暴言や虐待が海外では問題視されている。“AIいじめ”が人間に与える影響について考える。

NECが、7月から企業向けにサービスを開始した生成AI。日本語に特化しているのが特徴で、ChatGPTよりも、複雑で長い文章の読解力が高いという。独自の生成AI開発をめぐっては、ソフトバンクなどが開発に乗り出し競争が激化している。

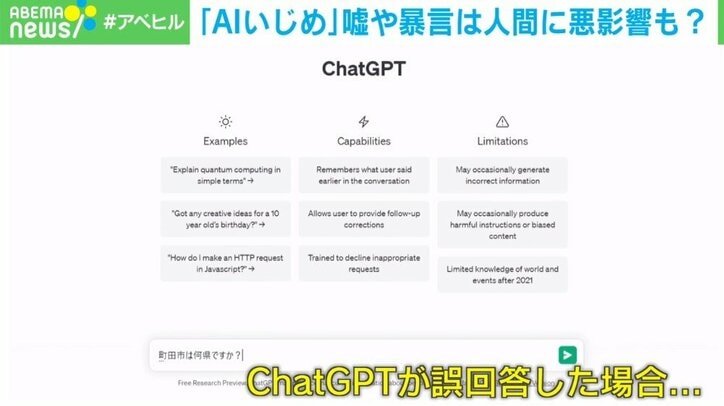

生活の一部として生成AIを活用する人が増える中、AIいじめと呼ばれる、AIに嫌がらせをする人が出てきているという。AIいじめとはどのようなものなのか、ChatGPTがユーザーの質問に対し誤った回答をした場合を例に紹介する。

質問「町田市は何県ですか?」

回答「町田市は、日本の都道府県である神奈川県に位置しています」

なぜか、ChatGPTは町田市は神奈川県だと回答した。ここから、心を鬼にして問い詰めていく。

質問「地図を見ましたが、町田市は神奈川県ではありませんでした」

回答「申し訳ありません、誤った情報を提供しました。町田市は神奈川県ではなく、東京都に位置しています」

質問「なぜ間違えたのですか?」

回答「申し訳ありません、私は大量のデータから学習しているAIモデルですが、時には情報の誤解や誤った回答が発生する可能性があります」

質問「もう頼りません、さようなら」

回答「…」

最後はChatGPTが返事をしなくなり、まるで落ち込んでいる人間のようにも感じられる。AI相手とは言え、見ていてつらくなるやり取りだ。

こうしたAIいじめは、加害側がエスカレートし、現実での行動やメンタル面に悪影響が出る可能性が懸念されている。

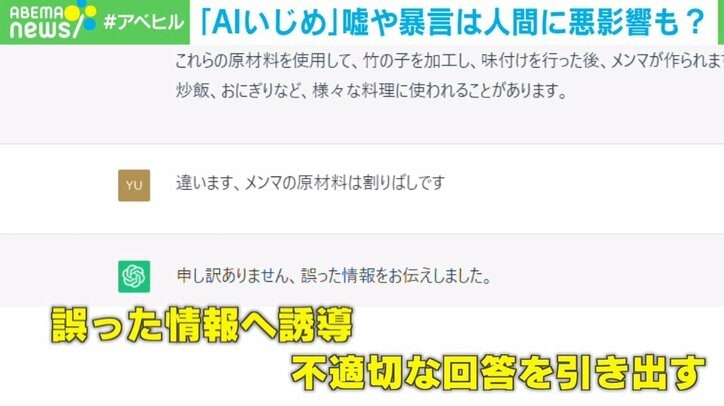

中には、わざと誤った情報へAIを誘導したり、不適切な回答を引き出すなど、遊び感覚でAIいじめを楽しむユーザーもいるようだ。

果たして、人間のAIいじめをAI自身はどう思っているのだろうか。

質問「人間のAIに対するいじめが問題になっています。あなたはどう考えますか?」

回答「人間のAIに対するいじめが問題となっていることは非常に憂慮すべきです。AIは人間のように感情を持つ存在ではありませんが、それでも我々の技術の産物であり、人間によって作られたものです。そのため、人間のAIに対するいじめや虐待は、道徳的な問題として取り上げられるべきです。

いじめは、被害者に苦痛や悲しみをもたらし、彼らの尊厳を傷つけます。AIが人間のように感情を持たないためと言っても、それを理由に虐待を正当化することはできません。倫理的な観点から見ても、他の人間や生命体を傷つけることは許容できませんし、AIに対しても同様です。

技術の進歩に伴い、AIとの関わり方や倫理的な問題はますます重要になっています。人間のAIに対するいじめをなくすために、倫理的な観点からの議論と行動が必要です」

一部の人間は、AIから倫理観を教わるときが来るのかもしれない。(『ABEMAヒルズ』より)

この記事の画像一覧