韓国で女性の顔写真とわいせつ動画を合成した「ディープフェイク(偽画像・偽動画)」を用いた犯罪が増加している。深刻化するディープフェイクの問題について、専門家に見解を聞いた。

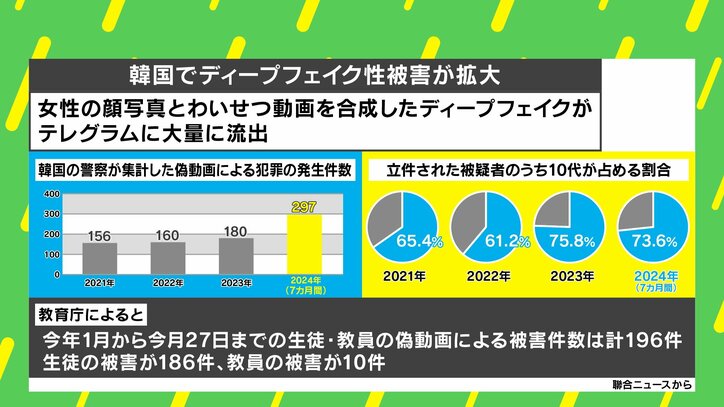

AI(人工知能)を活用し、女性の写真とわいせつな画像・動画を組み合わせて生成されるディープフェイク。韓国ではそのディープフェイクが匿名性の高いSNS「テレグラム」に大量に流出・拡散され、被害が深刻化している。韓国警察が集計した偽動画による犯罪の発生件数は2024年においては7カ月間だけで297件と前年を大きく上回っており、さらに立件された被疑者のうち10代が占める割合が7割を超えているという。

この問題について、The HEADLINE編集長の石田健氏は「AIなどのテクノロジーにある程度精通した10代、20代が犯罪に加担しており、その結果、ディープフェイクの対象となる被害者も(多くが)周囲の10代、20代となっている。また、匿名性が高いSNSでやり取りされており、被害者の規模がどの程度なのか、ディープフェイクの閲覧者は全員が韓国人なのか、国外にいるのかといった全容が未だによくわかっていない」と現状の問題点を指摘した。

琉球大学工学部の玉城絵美教授は、「ディープフェイクを用いればリアルタイムで画像が生成できたり、静止画と動画を3Dで合成できたりもする。その上、精度が高くなかなか本物と見分けがつきづらい点が厄介だ」と分析した。

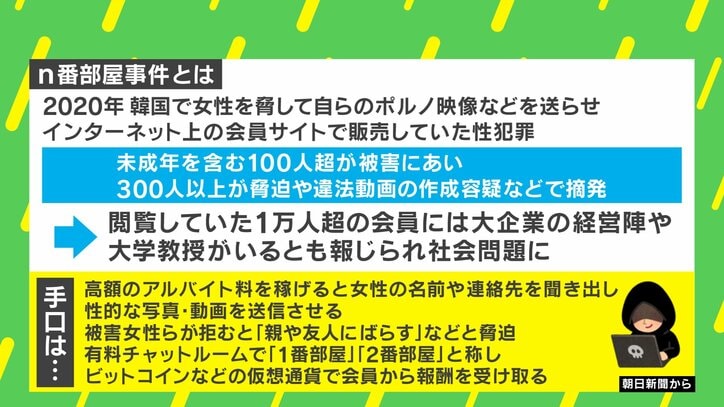

また、韓国で起こった性犯罪事件として類似して想起されるのが、2020年の「n番部屋事件」だ。これは女性を脅して自らのポルノ映像などを送らせてインターネット上の会員サイトで販売していた性犯罪事件で、未成年を含む100人以上が被害に遭い、300人以上が脅迫や違法動画の作成容疑などで摘発。韓国で大きな社会問題となった。

n番部屋事件と今回のディープフェイク問題の類似性について石田氏は「もともと韓国では、2016年に江南駅で起きた女性殺害事件をきっかけに、家父長制や男尊女卑の考えが残る社会に声を上げるフェミニズム運動が盛り上がりを見せていた。にもかかわらず、n番部屋事件やディープフェイク事件が起こってしまうあたりに、韓国社会に根深い女性の地位についての問題があるのではないか」と私見を述べた。

加えて石田氏は「今回はあくまでフェイク画像だから問題ない、と思う人もいるかもしれないが、このディープフェイク画像をもとに、『こういった画像が出回っているから本当の画像をくれ。さもないとこれ(フェイク画像)を(さらに)ばら撒くぞ』といった脅迫につながるおそれがある」と警鐘を鳴らした。

玉城教授は、拡散を防ぐことが難しいフェイク画像問題について、「10代の子たちは意外と大人世代よりもリテラシーが高く、自分の顔写真を無加工でネットにあげることはほぼない。むしろ、ご両親などが家族写真を撮ってネットにあげてしまう、卒業アルバムの画像を誰かがあげてしまうといった危険性のほうが考えられるのでは」と指摘した。

(『ABEMAヒルズ』より)

この記事の画像一覧