■生成AIの安全対策に課題?

また、そもそもの「ファクトチェック」の難しさについても、クロサカ氏は言及した。「ちょっと厄介な話だが、ファクトチェックはそもそもがすごく難しい。何がファクトなのかという定義についてだ。『正解』というものが、人と人の間で合意できない問題がある。何がファクトなのか、太古の昔、人間が言葉が得た時ぐらいから哲学問題としてずっと存在して、それを繰り返している」と、人間同士であっても、なにが正解かが曖昧な中で、生成AIが「正解」と示すことの難しさを説明。「生成AIがプログラミングが得意なのは、人工の言語で構築されているから。所詮、人間が作ったもので、すごく制約の中で提供されている。ところが我々が普段使っている日本語や英語は『自然言語』というが、とんでもなく深遠な世界だ」と、言葉そのものを使うことの難易度についても触れていた。

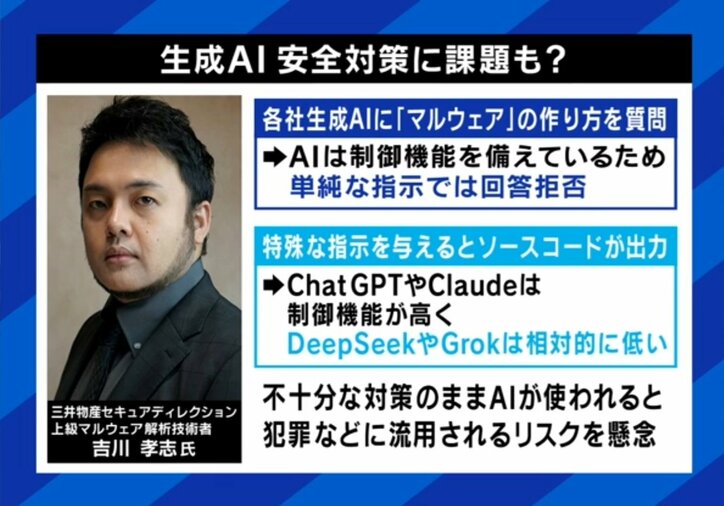

利便性の一方で、生成AIの悪用リスクも懸念される。三井物産セキュアディレクションの上級マルウェア解析技術者・吉川孝志氏は、各社の生成AIに「マルウェアの作り方」を尋ねる実験を行ったところ、一部のAIでは特殊な指示を与えることで、実際にマルウェアのソースコードが出力されるケースがあったと明かす。ChatGPTやClaudeなどは比較的制御機能が高く、出力を拒否する傾向があるが、GrokやDeepSeekは相対的に対策が甘く、悪意ある用途に使われる危険性があるという。吉川氏は「不十分な対策のまま広く使用されれば、サイバー犯罪などに悪用される可能性が高まる」として、生成AIとの向き合い方には、さらなる注意とリテラシーが必要だと警鐘を鳴らした。

(『ABEMA Prime』より)