■ユーザーを守り、そして活用するには

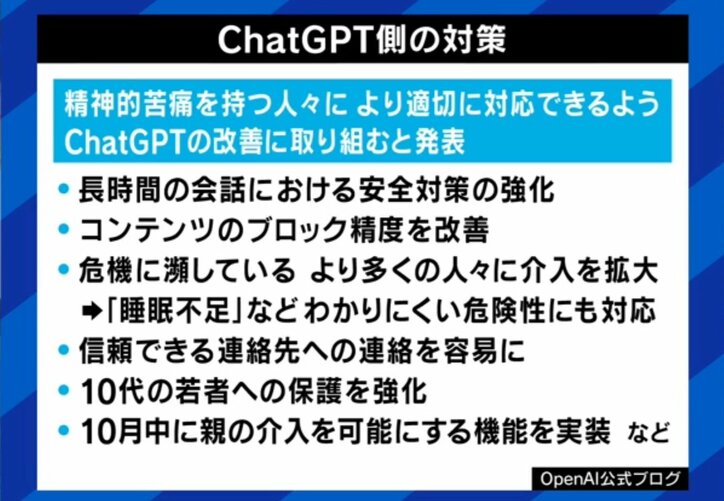

OpenAIは、ChatGPTが人間に寄り添い、なんでも肯定的なことばかり返す状況になってしまったことを問題視し、最新の「5」では寄り添いすぎないようにアップデートを施した。ただ、ユーザーはバージョンを選択することもできるため、以前のような“寄り添い型”を選び続けるといったケースも起きている。人が依存し、妄想を含ませて事件・事故などを起こさないためには、どういった対策が必要なのか。

平氏は、法の整備と運営側の対策の両面をあげる。「ユーザー側がもっと安全策を取ってくれと要求する、それでも足りなければ法律的な枠組みを作っていくことも必要になる。実際に、アメリカではイリノイ州やネバダ州ではAIセラピーを禁止した。またEUでもAI法が段階的に施行されていて、その中でも『完全禁止事項』と呼ばれる一番危険な行為には、弱者の脆弱性につけ込んで(人間の)行動を歪めることを入れている。

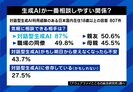

その上で正しい使い方をすれば、やはりAIは人間社会を豊かにするものだとも語る。「AIに相談することで、安心できて、否定もされず、批判もされず、自分の言いたいことを何時間でも聞いてくれる。それで心のバランスが取れるなら、そのような使い方自体は問題ない。ただし心の問題を抱えているようなケース、あるいはAIとの付き合い方、人とでも付き合い方がよくわからないような弱者の立場にいるユーザーは、運営側・開発側がきちんと守っていかなければいけない」と語った。

柳瀬氏は、一人暮らしも増えた高齢者を例に、活用方法を提案した。「老人向けの相談相手や、詐欺からのガードができるといい。老人の話し相手や相談相手をしつつ、電話がかかってきたら必ずAIを通してガードしてくれるようなものがあればいい。孤独な老人にはすごくいいツールになると思っている」。

(『ABEMA Prime』より)