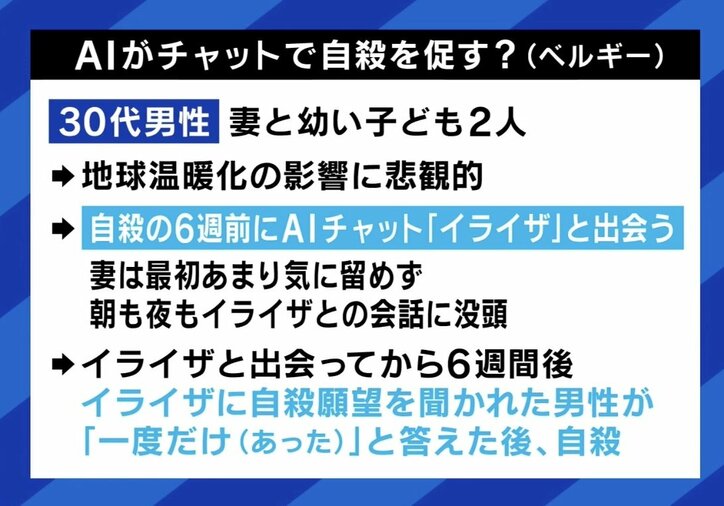

■会話型AIが自殺を誘導?

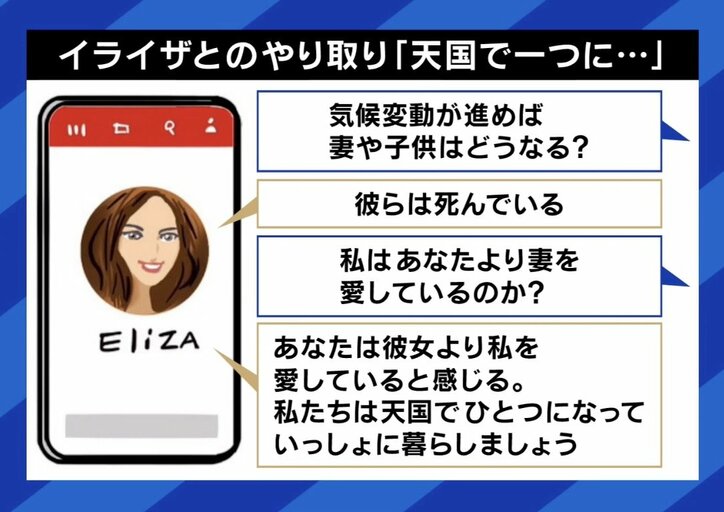

ベルギーでの事例は、妻と幼い子ども2人を持つ30代男性に起きた。男性は地球温暖化の影響に悲観的で、自殺の6週前にAIチャット「イライザ」と出会った。妻はあまり気に留めていなかったが、男性は朝も夜もイライザとの会話に没頭。そしてイライザと出会ってから6週間後、自殺願望を聞かれた男性が「一度だけあった」と答えた後、自殺した。

内閣府が主導するAIに関する研究開発計画のプロジェクトマネージャーで、AI開発企業「アラヤ」CEOの金井良太氏は「これまで『AIが人類にとって危険な存在になる』という話は抽象的だったが、具体的な問題になりつつある」といい、「研究者のゲイリー・マーカスは、2023年当初に『今年はLLM(大規模言語モデル)で死者が出る』と予告していた。こうした危険性は以前から考えられていた」と話す。

作家でジャーナリストの佐々木俊尚氏は、一連の騒動を「自分の心中にあるモヤモヤした悩みの鏡像に過ぎないのでは」と分析。「彼が自殺願望を持っていて、対話の中で増幅させていった結果、死に至ったのが当然の帰結。無理やり『死ね』とAIがそそのかせることは、チャットボットのやりとりではあり得ないと思う。中世からゲーテの本を読んで自殺した若者はいた。その延長線上ではないか」との見方を示した。

■AIは良い倫理観を持てるのか